Compartir este artículo

El uso de la inteligencia artificial en los últimos meses se ha incrementado, lo cual ha traído beneficios no solo para la tecnología, sino en otros ámbitos de la vida como son la medicina, mejoras en la fabricación, energía más sostenible a un mejor precio y transporte más seguro y limpio. Sin embargo, aunque haya traído y seguirá trayendo múltiples beneficios en muchas áreas, no es un tema que se pueda dejar a la ligera y se deben establecer parámetros, por lo que la UE comienza a establecer reglas para el uso de las IAs.

El 16 de junio de 2023 se han anunciado las primeras clasificaciones de riesgo para los sistemas de IA, junto con la implementación de diversos niveles de regulación que les serán aplicados.

No en vano un grupo de personas expertas, entre ellos ejecutivos e ingenieros, de las principales empresas de IA, como: Demis Hassabis (Google DeepMind), Dario Amodei (Anthropic) y Sam Altman (de OpenAI), expresaban su preocupación y exponían que “la inteligencia artificial (IA) supone un “riesgo de extinción” para la humanidad”. El Centro para la Seguridad de la IA”, organización sin fines de lucro, indicaban en su comunicado que “Mitigar el riesgo de extinción de la humanidad de la IA debería ser una prioridad mundial junto con otros riesgos a escala social, como las pandemias y la guerra nuclear”.

Es por esto que la Unión Europea comienza a dar sus primeros pasos y es la pionera en el mundo para establecer reglas en el uso de la IA. A partir de abril de 2021, se presentó el primer marco regulatorio que planteaba la evaluación y clasificación de los sistemas de IA según el riesgo que puedan representar para los usuarios. El 16 de junio de 2023 se han anunciado las primeras clasificaciones de riesgo para los sistemas de IA, junto con la implementación de diversos niveles de regulación que les serán aplicados.

Medidas que trazarán el marco del uso de los sistemas de IA en la UE

Estas medidas deben priorizar que los sistemas sean transparentes, no discriminatorios, respetuosos con el medio ambiente y sobre todo seguros. Además, se establecerá que no deben operar de manera autónoma, sino que siempre deben estar supervisados por personas reales, evitando así posibles daños irreparables y descartando la autorregulación o la automatización.

La normativa establece distintos niveles de riesgo según el uso que se dé a los sistemas de IA, los cuales serán obligatorios tanto para proveedores como para usuarios, dependiendo del nivel de riesgo que represente, las cuales van desde: riesgo inaceptable, alto riesgo, IA generativa y riesgo limitado.

Con relación al Riesgo inaceptable:

Son lo que se consideran una amenaza para las personas y estos serán terminantemente prohibidos. Para ser clasificados como inaceptables estos supondrán tener o hacer uso de:

- Manipulación cognitiva del comportamiento: tanto de personas como de niños, un ejemplo de esto podrían ser los juguetes activados por voz que animan a conductas peligrosas en los pequeños.

- Puntuación social: aquí se refiere a clasificar a las personas de acuerdo a su estatus socioeconómico, comportamiento, o características personales.

- Sistemas de identificación biométrica en tiempo real y a distancia, como el reconocimiento facial. (En el caso de los sistemas de reconocimiento facial, existen algunas excepciones. Por ejemplo, los sistemas de identificación biométrica a distancia, se permitirán para perseguir delitos graves y solo en el caso de que haya una previa aprobación judicial).

Para los sistemas de Alto riesgo:

Entrarán en esta clasificación, aquellos que afecten negativamente a la seguridad a los derechos fundamentales y estarán divididos dos categorías.

- Los sistemas de IA que se utilicen en productos sujetos a la legislación de la UE sobre seguridad de los productos: juguetes, aviación, automóviles, dispositivos médicos y ascensores.

- Los sistemas de IA pertenecientes a ocho ámbitos específicos que deberán registrarse en una base de datos de la UE:

-

- Identificación biométrica y categorización de personas físicas.

- Educación y formación profesional.

- Gestión y explotación de infraestructuras críticas.

- Acceso y disfrute de servicios privados esenciales y servicios y prestaciones públicas.

- Aplicación de la ley.

- Empleo, gestión de trabajadores y acceso al autoempleo.

- Asistencia en la interpretación jurídica y aplicación de la ley.

- Gestión de la migración, el asilo y el control de fronteras.

Todos los sistemas clasificados de alto riesgo se evaluarán antes de ser comercializados y a lo largo de su ciclo de vida.

Los sistemas clasificados como IA generativa:

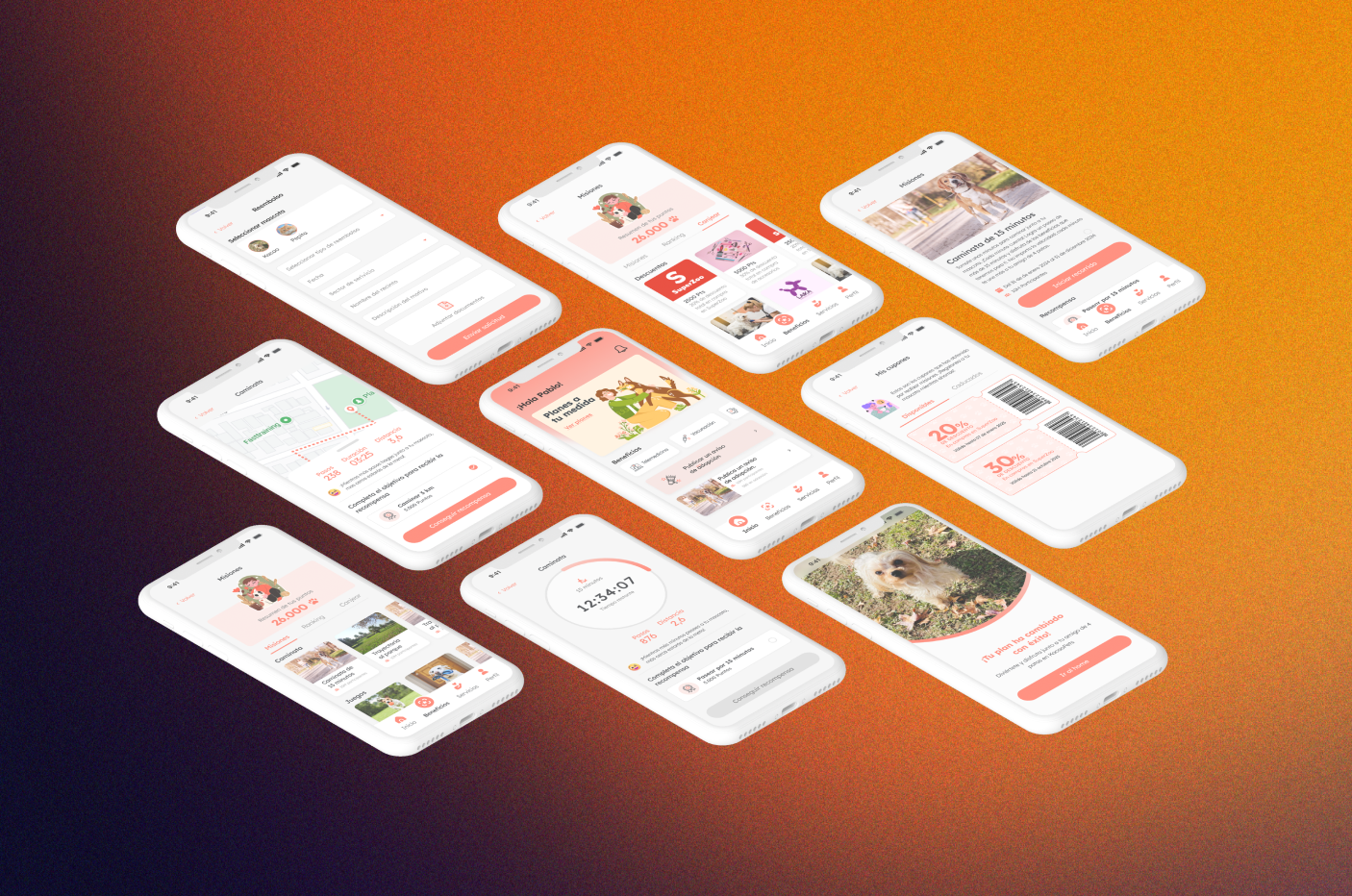

En este tipo de clasificación entrarían IAs generativas como ChatGPT deberán cumplir ciertos requerimientos de transparencia.

- Deberán exponer que el contenido creado ha sido generado por IA.

- Diseñar el modelo para evitar que genere contenidos ilegales.

- Publicar resúmenes de los datos protegidos por derechos de autor utilizados para el entrenamiento.

Las IA clasificadas de Riesgo limitado:

Estos sistemas deben satisfacer ciertos estándares básicos de claridad que permitan a los usuarios tomar decisiones de manera informada. Es decir que tras su uso el usuario tenga la libertad de decidir si desea seguir utilizándola o no y estos deben ser conscientes de que están interactuando con IA, lo que indica que aquellas que generan o manipulan contenidos de imagen, audio o vídeo deben dejarlo saber.

Postura de Open IA sobre retirar ChatGPT de la Unión Europea.

Cuando se comenzó a hablar sobre el uso desmedido de ChatGPT en Europa y que las intenciones de la Unión europea era crear medidas para controlarlo, Sam Altman, había indicado que se llevaría a ChatGPT de Europa, si las restricciones eran demasiado estrictas y entendían que no podrían cumplir con ellas, pero luego en un tuit publicado en mayo 2023, indicó que «no tiene planes» de llevarse ChatGPT de Europa”.

¿Qué pasos seguirán?

Los eurodiputados adoptaron su posición sobre la ley de IA. Continuarán las conversaciones sobre la forma final en la que quedará establecida en el Consejo, junto a los todos los países que representan la UE. Su meta es poder llegar a un acuerdo a finales de este 2023.

Mira aquí el Informe de Ley sobre inteligencia artificial